El pasado diciembre, se celebró un día de charlas sobre tecnologías de Google en Londres. Un evento llamado GDG London (Google Developers Group London) DevFest. Este evento lo organiza la comunidad de desarrolladores de software voluntarios que ponen el foco en tecnologías y proyectos de Google.

En esta ocasión la conferencia fue dividida en 4 salas diferentes, cada sala trataría un tema diferente: Cloud y Machine Learning, Web, Mobile y Assistant.

Es la primera vez que había un track especializado del famoso asistente de Google, así que Aura, la inteligencia artificial de Telefónica, quiso estar allí.

En el equipo de prototipado de Aura, nos dedicamos a probar nuevas ideas para mejorar las capacidades de nuestra inteligencia artificial. Así que, dadas las características de la conferencia seguro que podíamos aprender sobre la comunidad que desarrolla software para asistentes, los proyectos con asistentes y ver ideas frescas.

Tabla de contenidos

Hey Google, what is possible with Actions on Google?

— Rose Grundy (https://twitter.com/roseanna_g)

Y así comenzó la charla con una introducción general de las últimas novedades de Google Assistant de la mano de Rose. Novedades generalmente orientadas a mejorar la experiencia del usuario o del desarrollador.

Continued Conversation

Esta fue la mayor funcionalidad publicada en el último Google I/O el pasado Mayo, junto con Duplex. Trata de evitar que el usuario diga “Ok Google” cada vez que quiera hablar con el dispositivo. Esto quiere decir que el dispositivo siempre está escuchando una vez que invoquemos al asistente.

Actions Templates

Son plantillas que nos permiten desarrollar una app en minutos mediante un Google Sheet, el excel de Google Apps. Con esto quieren abrir el círculo del desarrollo a personas que no tengan habilidades de programación muy desarrolladas pero con ideas para hacer un app en un asistente.

Sample Actions

Estos son los ejemplos que tiene Google para que los desarrolladores puedan empezar sus proyectos con alguna base. Siempre apoyándose en la plataforma Dialogflow, que facilita la creación de estás apps de tal forma que no haga falta una línea de código para tener una app funcionando.

Table Card

Es la nueva solución gráfica destinada especialmente para facturas o cualquier tipo de datos tabulados.

Theme customization

Con la personalización de los temas Google Assistant permite a los desarrolladores diferenciar sus actions permitiendo personalizar el color de fondo, color principal de las cards, tipografía, tipos de bordes de las tarjetas e imagen de fondo, en este caso no se mostraría el color de fondo.

Last seen tag

Para ayudar a fortalecer el contexto de la conversación, Google Assistant ha introducido un tag dentro de la información de usuario que ayudarará a los desarrolladores a retomar la conversación donde la dejaron.

En Aura ya hemos iniciado la investigación para añadir algunos de estos componentes, aunque concretamente en Brasil ya hemos usado la personalización de temas para nuestra app en Google Assistant, y es bastante útil para diferenciar tu app.

Talk to me

— Adi Mazor Kario (https://twitter.com/AdiMazorKario)

Aquí, la ponente, nos introdujo, desde el punto de vista de Proucto y UX, el diseño de conversación. Conociendo el auge de los interfaces con reconocimiento de voz y las búsquedas en internet por voz es un aspecto que debemos empezar a cuidar.

Fue una charla muy interesante porque ponía el foco en lo que el proyecto Aura, estamos mejorando. Estos nuevos términos están empezando a propagarse y nos gustó ver que dirección llevan otras empresas y poder comparar.

Todos los implicados en el mundo de los asistentes nos hacemos la pregunta “¿Cómo será el futuro?”, y Adi nos ofreció una serie de puntos para ayudarnos a respondernos.

- Las conversaciones serán sin fricciones y más naturales.

- Los asistentes serán más humanos.

- Conocerán tu personalidad.

- Comunicarán con un carácter.

- Reaccionarán a tus emociones.

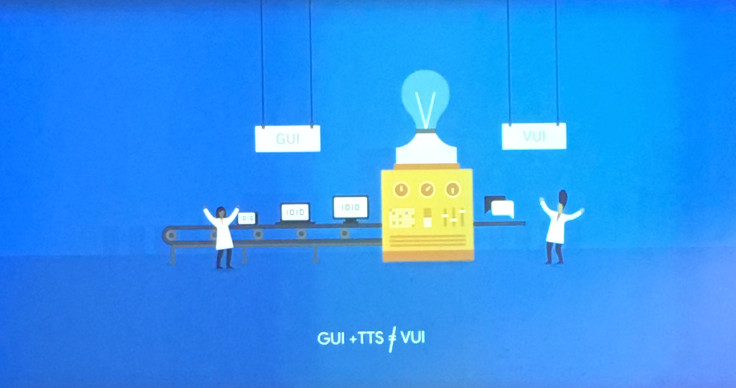

Para llegar a este idílico futuro, Adi, comentó que para una conversación la vista no funciona igual que el oido. Hay que preparar la conversación sabiendo que lo primero e importante es la interacción vocal.

Y nos propuso el siguiente esquema de trabajo:

- El diseño de la conversación. Analiza los requirimientos: identifica a tus usuarios, los casos de uso clave y crea un personaje para tu asistente. Haz un boceto rápido de la conversación, de solo una parte la consideres principal. Ahora piensa si este boceto escalaría.

- La conversación es lo primero. Empieza como si fuera el guión de una película. Imagina como fluiría tu conversación ideal y haz un mapa de la conversación con las posibles interacciones.

- Happy Path / Error path. Cada caso de uso tiene que tener definido el caso de exito y el caso de error en la conversación. Es importante que no olvidemos esto. En muchos casos el tratamiento de errores caen en el olvido, y es algo que desconcierta mucho al usuario cuando sucede.

- Repasa los principios para crear una conversación. Respeta los turnos de palabra. Respeta el principio de cooperación entre tu asistente y el usuario. Asegurate que tu asistente sabe tejer la conversación, contextualizar, contempla las variaciones del lenguaje y es capaz de enmendar los errores que pueda cometer.

- Validar la conversación. Utiliza algunas herramientas o técnicas para validar una conversación, como, la lectura en voz alta. Es constructivo escuchar el punto de vista de personas que no estén relacionadas con el proyecto. Nuestras ideas ya están viciadas por el contexto. Si es posible, pruébalo ante usuarios regulares de asistentes virtuales.

- Apoya tu VUI con GUI. No lo hagas al revés. Prueba primero la conversación en la experiencia solo de voz, y luego añade el soporte visual.

Para finalizar, Itera. Necesitamos hacer este recorrido tantas veces como sea necesario, hasta que veamos limadas todas las aristas de nuestra experiencia.

Zero to App: Building for the Google Assistant Using Dialogflow and Firebase

— Aygul Zagidullina (https://twitter.com/aygul)

— Kaan Mamikoglu (http://twitter.com/kaanmamikoglu)

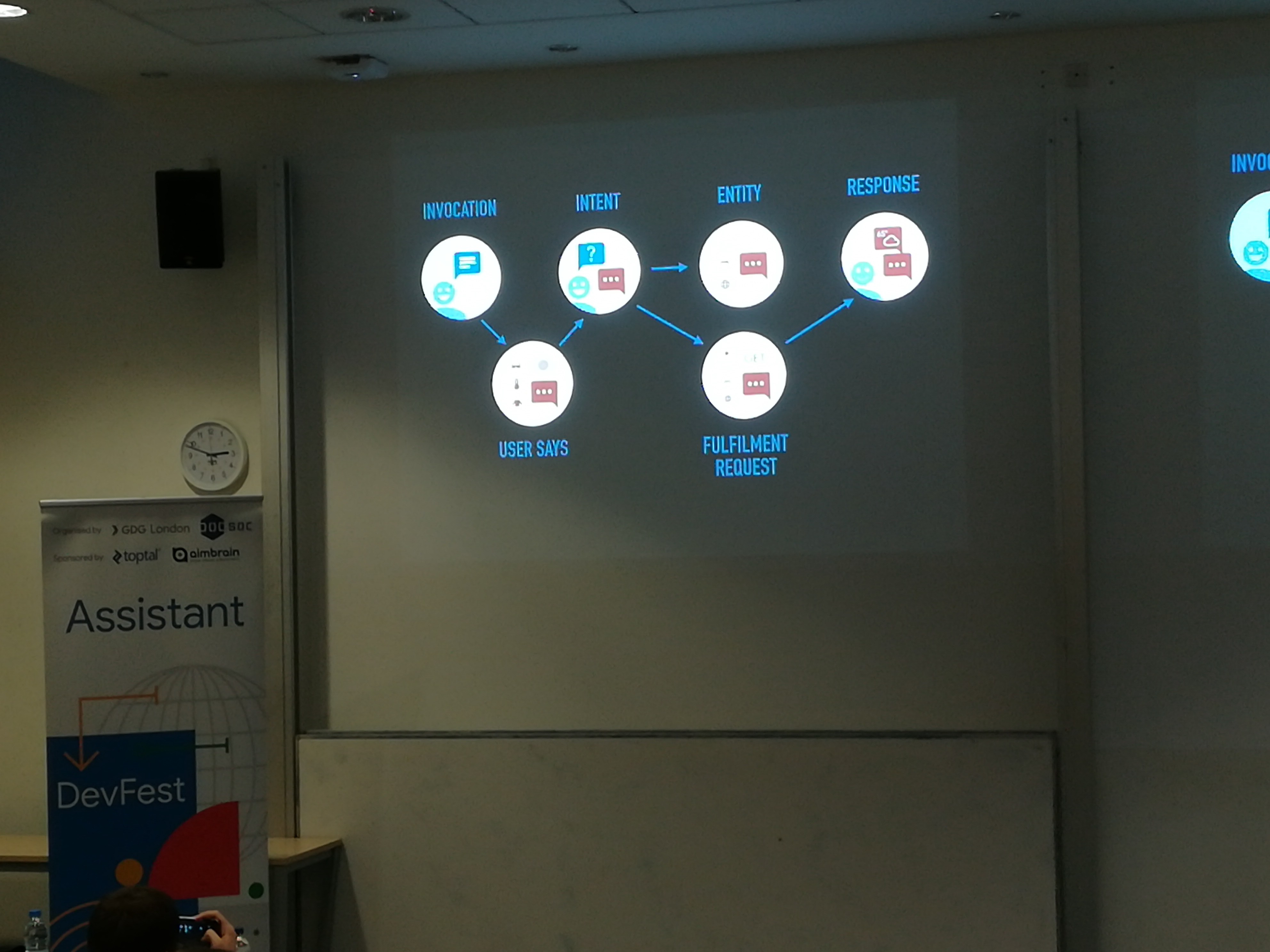

En esta sesión Aygul y Kaan, que eran parte del staff que organizaba el evento, nos explicaron como mezclar Actions on Google, Dialogflow y Firebase, todas ellas tecnologías de Google para crear una experiencia completa dentro del asistente.

Desde Aura seguimos con interés estas tecnologías y actualmente las usamos para prototipar pequeños proyectos. Así que, la charla no nos pilló por sorpresa.

Aygul, se centró en la parte de crear la app con Dialogflow. Nos contó los consejos para sacar el mayor partido a esta herramienta y así apoyar la experiencia de Actions on Google.

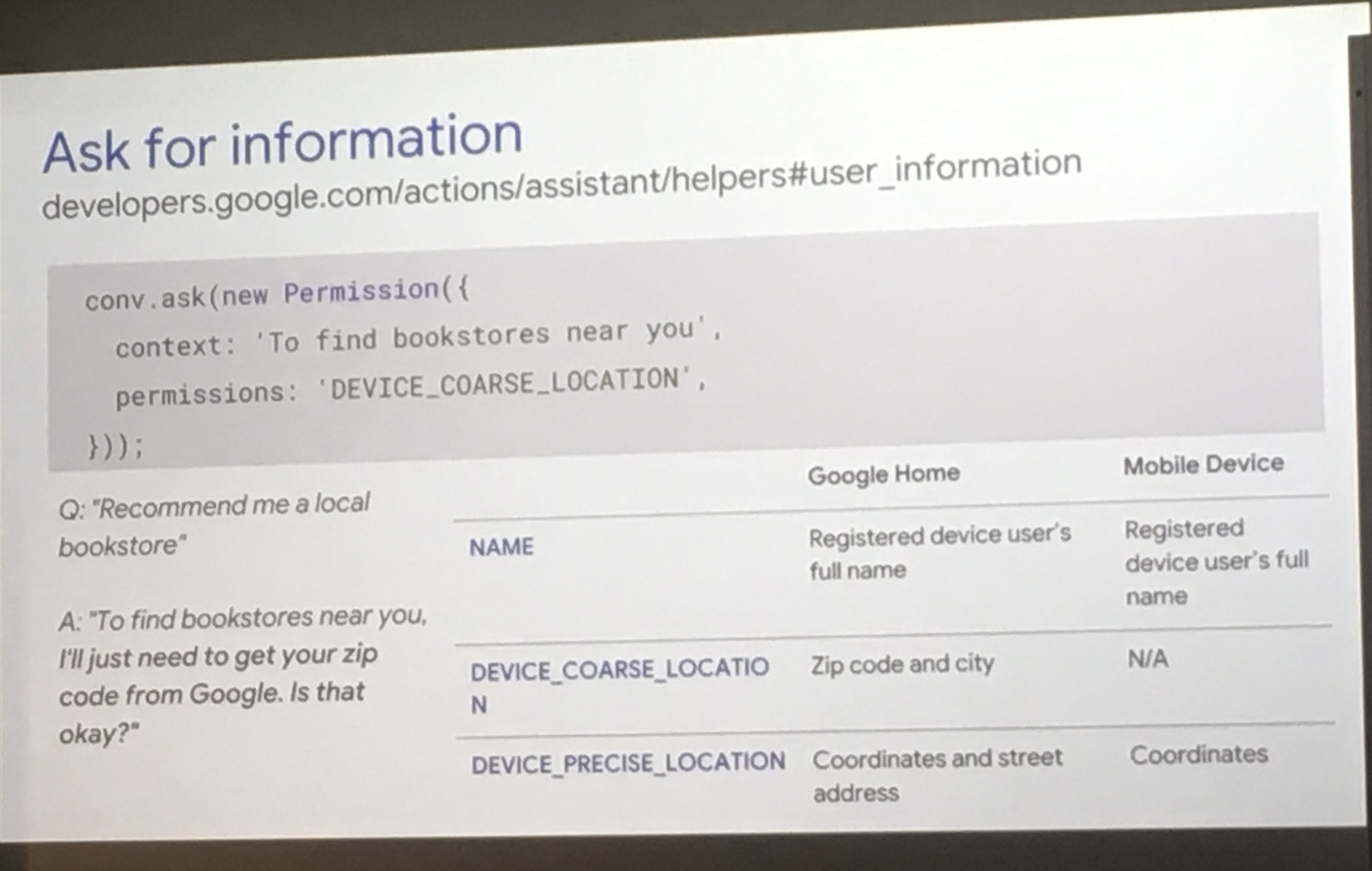

Una de las partes más destacadas es saber como preguntar por información al usuario. Por ejemplo pedir permiso para activar la localización.

Preguntar por información de usuario.

Preguntar por información de usuario.

Nos enseño las mejoras que Actions on Google ha introducido en account linking, configurable con dos modalidades:

- Para Multiplataforma Google Sign in + OAuth linking.

- Para Assistant solamante Google Sign in.

Kaan, expandió la experiencia que tenía Aygul usando 2 herramientas de Google:

1. Cloud Firestore. Una base de datos en Cloud que ofrece: sincronización, resolución de conflictos, uso offline, una estructura de datos flexible y escala automáticamente. La herrmienta perfecta para almacenar datos multi usuario con flexibilidad.

2. Cloud Storage. Es una base de datos en Cloud que ofrece comparativamente con lo anterior: robustez, seguridad y escalabilidad. Destinada para guardar información más relevante o que necesite más seguridad.

De forma que nos ofrecieron un proyecto con Dialogflow extendiendo las capacidades y le dieron potencial para crecer con Firebase.

Building conversational interfaces for Google Assistant

— Martin Hawksey (https://twitter.com/mhawksey)

En su tiempo, Martin, nos habló de como combinar Google App Scripts y Dialogflow para hacer un bot en Google Hangouts.

Sí, Google Hangouts ofrece una solución donde sus bots pueden responder desde acciones en Google App scripts.

Los Google App scripts son scrips que permiten hacer operaciones sencillas sobre las Apps de Google como mail, drive, calendar, docs, slides en pequeñas funciones de un lenguaje parecido a javascript y ejecutadas en Google Cloud.

Así que la idea fue ver cómo Martin construyó el bot desde Google Hangouts, cómo el bot atiende a las respuestas desde Google App Scripts o desde Dialogflow cuando sea requerido.

Para poder disponer de estas operaciones necesitamos hacer una pequeña configuración:

- Generar un service account key en Dialogflow.

- Subir ese Json a google drive de forma que podamos enlazarlo.

- Añadir la referencia a ese fichero en el proyecto de Google App script

Aquí puedes ver el código y explicación detallada de lo que nos contó Martin.

Esta charla fue quizás la menos relacionada con lo que hacemos en Aura pero aprendimos nuevas ideas como los bots de Google Hangout.

Learning to play the guitar with Actions on Google

— Joe Birch (https://twitter.com/hitherejoe)

Para seguir con la tarde, Joe nos presentó un proyecto personal en el que ha completado una app dentro de Actions on Google, usando Dialogflow y Firebase.

Parece que las herramientas empiezan a ser comunes en las presentaciones. Todos los ponentes excepto uno se han apoyado en Dialogflow y muchos también se apoyan en Firebase para almacenamiento de datos. Joe usó Actions SDK con Dialogflow y hosteó su bot en una función de Firebase. El ecosistema que Google está abriendo para los desarrolladores es bastante intuitivo y ofrece muchas posibilidades para crear una app.

Para hacer prototipos rápidos, tanto Dialogflow y Firebase son herramientas perfectas. Se añaden facilmente, tienen una documentación sencilla y tienen un buen plan gratuito. En el equipo de prototipos de Aura es uno de nuestros combos favoritos para las demos.

Tanto Adi, antiormente, como Joe insistieron en la idea de crear primero la experiencia de voz y luego darle soporte visual para reforzar la experiencia. No al contrario.

La app que construyó Joe es una app donde preguntas por un acorde de guitarra y te dice como tienes que colocar la mano. De forma que en poco tiempo puedes empezar a tocar la guitarra.

Building assistive apps with App Actions

— Elaine Dias Batista (https://twitter.com/elainedbatista)

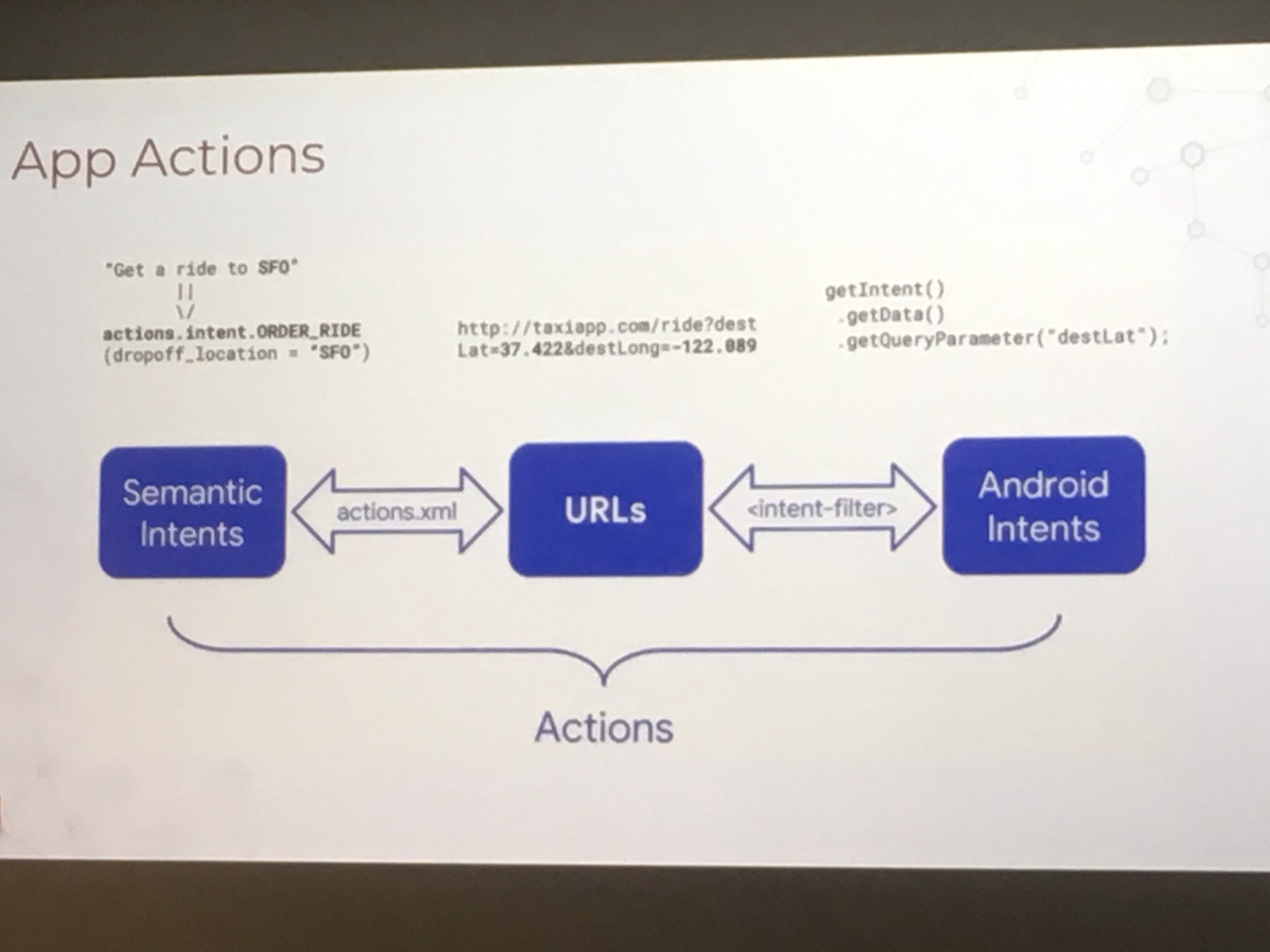

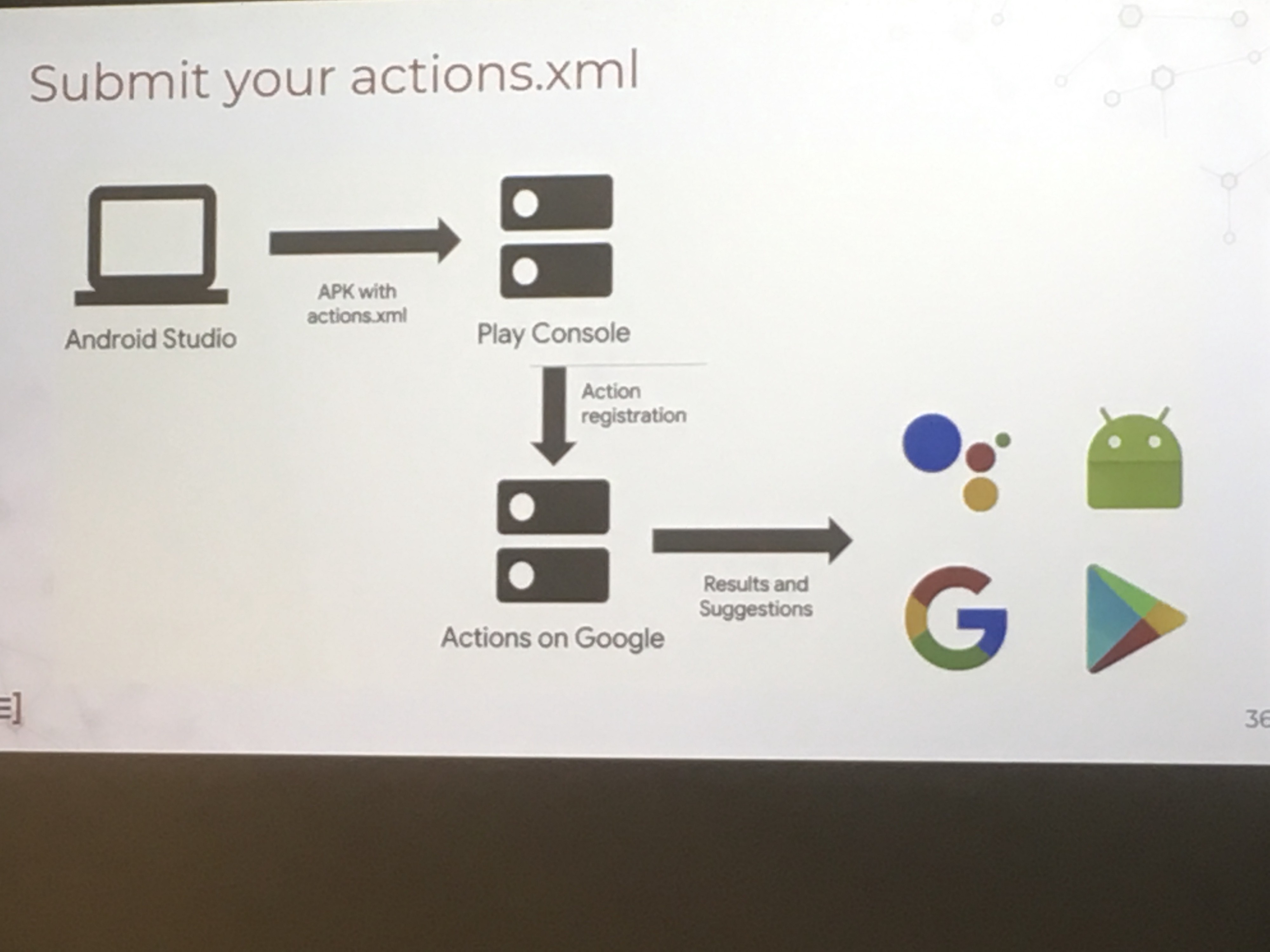

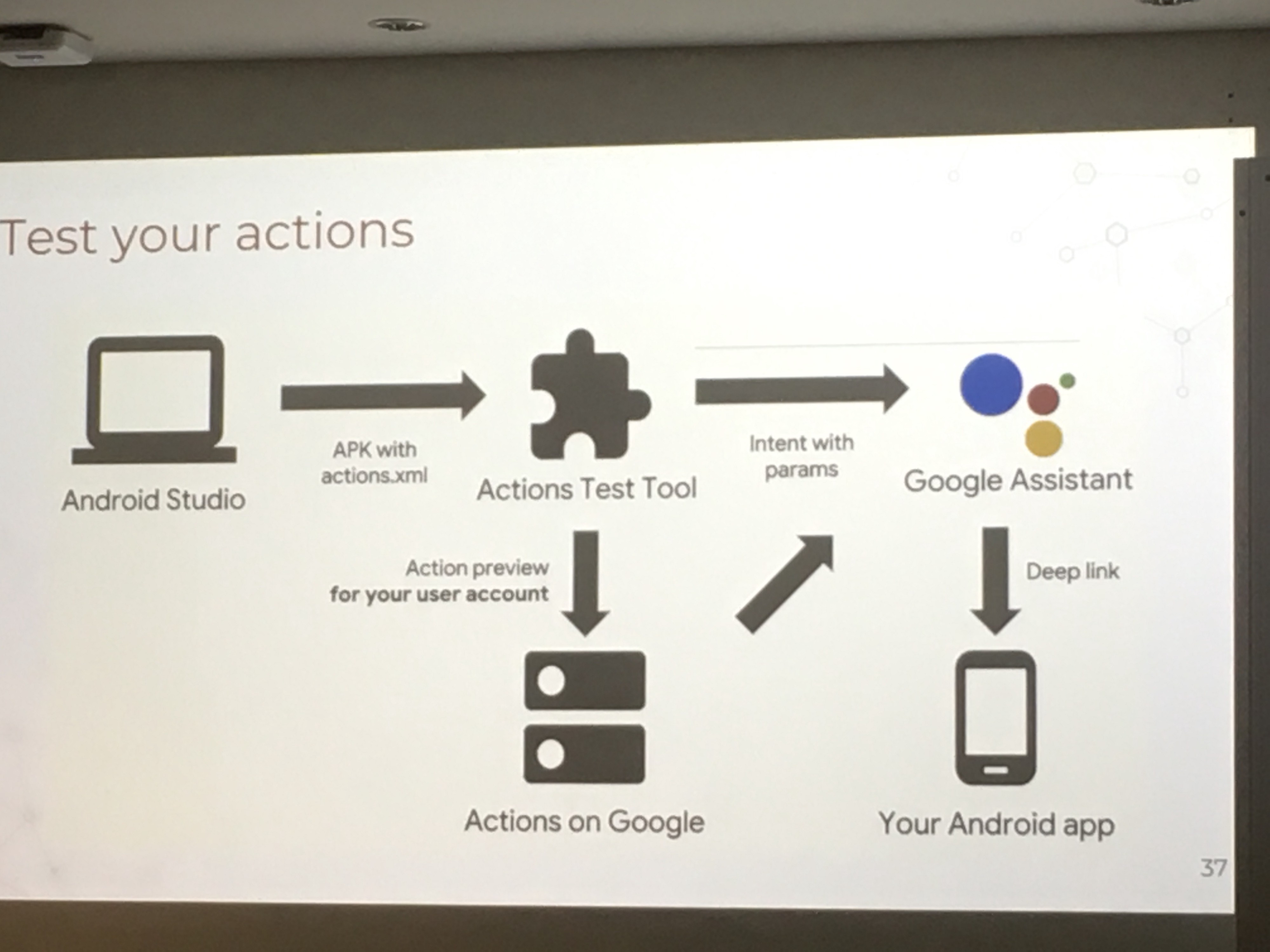

Eleaine, que es Google Developer Expert de Android, empezó describiendo el recorrido que ha seguido Android hasta llegar al concepto de App Actions. Como en 2017 empezaron con las filas de predicciones de apps con una tasas del 60% de predicción, y como en 2018 se fraguó el concepto de App Actions https://developer.android.com/guide/actions/.

La idea que Android está lanzando es asociar la app que estamos corriendo a un intent de forma que sea visible en multiples superficies. Se pueden asociar las apps con intents que ofrece Android o crear intents personalizados.

Esto todavía no ha sido lanzado en Android, aunque la idea es muy interesante para aquellos que tengan una app en Android y quieran continuar la experiencia desde Google Assistant.

La segunda derivada sería extender la experiencia de de las App Actions a Conversational Actions, que serían las acciones conversacionales lanzadas desde un asistente, Google Assistant en nuestro caso.

De forma que, como Elaine sugería, fuera posible mapear Intents de Google Assistant a Built-in intents de Android.

Para Aura esto sería una buena forma de relacionar las apps de Android donde tenemos presencia, con intents de la conversación que pueda tener Aura en sus apps de Google Assistant. Ganando así recurrencia de usuarios y mejor accesibilidad

Beyond Smart Speakers: Get Your Google Assistant Apps Ready for Smart Displays

— Aygul Zagidullina (https://twitter.com/aygul)

Última de la charlas, de nuevo la organizadora Aygul nos cuenta buenas prácticas para implementar nuestra app dentro de Actions on Google y cómo hacer nuestra app más visible para los usuarios. Lo importante de manejar las invocaciones explícitas e implícitas.

Fue el perfecto resumen de muchas cosas que vimos a lo largo del día.

Por último nos reveló la noticia sobre el último dispositivo, todavía no disponible en España, un altavoz con pantalla llamado Google Home Hub.

Como curiosidad, en comparación con nuestro Movistar Home, no tiene cámara porque parece estar destinado a conquistar el dormitorio.

Aprendizajes

En Aura estamos siguiendo un camino parecido a lo que hacen compañias como Google, que tienen mucho más presupuesto y con más gente involucrada en la resolución de los problemas.

En cuanto a talento, esfuerzo e ideas estamos bien situados.

Gracias por leerlo.